Kernpunkte:

- Big Data und Scoring

- Soziale Netzwerke

- Innere Sicherheit

8 Modellprojekte und Studien

Neben seiner Prüf- und Beratungstätigkeit beteiligt sich das ULD an drittmittelfinanzierten Projekten und Studien mit besonderem Datenschutzbezug. Ziel ist es, über das gesetzlich notwendige Mindestmaß an Datenschutz hinauszugehen und besonders „datenschutzfördernde Technik“ zu entwickeln, die den Bürgerinnen und Bürgern in Schleswig-Holstein zugutekommt. Durch diese Aktivitäten profitiert das Land finanziell und in Form von Kompetenzbündelung im Bereich Datenschutz (Tz. 8.1–8.7). Die vielfältigen Projektbeteiligungen zeigen, dass nationale und internationale Forschungseinrichtungen das Datenschutz-Know-how aus Schleswig-Holstein als einen wichtigen Bestandteil der technischen Entwicklung sehen.

Die Projekte werden im ULD durch das Innovationszentrum Datenschutz & Datensicherheit (ULD-i) koordiniert, das interessierten schleswig-holsteinischen Unternehmen und Hochschulen für die Integration von Datenschutz und Datensicherheit in ihre Projekte und Produkte zur Verfügung steht. Bei der Gestaltung von Systemen sollen Datenschutzanforderungen von Anfang an einbezogen werden; dieses Grundanliegen des ULD wird voraussichtlich mit der kommenden EU-DSGVO Pflicht für alle verantwortlichen Stellen (Tz. 2.2) und ist deshalb ein Schwerpunkt der Projektarbeit des ULD. Im Berichtszeitraum 2013-2014 hat das ULD sich an Projekten zu vielen aktuellen und wichtigen Themen beteiligt: Grundlagenforschung zu Privatheit (Tz. 8.1), Identitätenmanagement (Tz. 8.2), Cloud Computing (Tz. 8.3), Cybersicherheit (Tz. 8.4), Big Data (Tz. 8.5), Sicherheit (Tz. 8.6) und Betroffenenrechte (Tz. 8.7).

http://www.uld-i.de/

8.1 Forum Privatheit und selbstbestimmtes Leben in der digitalen Welt

Das gemeinsame Erarbeiten von Lösungen in einem interdisziplinären Team bewährt sich in der Projektarbeit des ULD. Zwar prallen manchmal die Sichten von Recht, Informatik, Betriebswirtschaft und Sozialwissenschaften aufeinander, doch dann wird gemeinsam um tragfähige Lösungen gerungen, in denen die Grundrechte hochgehalten werden. Der interdisziplinäre Diskurs steht auch im Vordergrund in dem vom Bundesforschungsministerium geförderten „Forum Privatheit und selbstbestimmtes Leben in der digitalen Welt“ (kurz: Privacy-Forum).

Seit Ende 2013 ist das auf drei Jahre angelegte Privacy-Forum aktiv; das ULD kam im Herbst 2014 als Projektpartner hinzu. Wissenschaftler aus der Ethik, Informatik, Jura, Ökonomie, Politologie, Psychologie und Soziologie arbeiten interdisziplinär zum Thema „Privatheit in der digitalen Welt“ an einem gemeinsamen Verständnis und Konzepten für eine (Neu-)Bestimmung und Gewährleistung der informationellen Selbstbestimmung. Die Projektpartner sind sowohl an gemeinsamen Themen als auch an individuellen Schwerpunkten tätig. Die „White Paper“ zu Selbstdatenschutz und zum versteckten Internet, die über die Projekt-Webseite veröffentlicht sind, richten sich an interessierte Bürgerinnen und Bürger, können aber auch als Grundlage für politische Entscheidungen dienen. Weitere Ausarbeitungen mit unterschiedlichem Adressatenkreis werden folgen.

Das ULD wirkt an dem Forum als Schnittstelle zwischen der Praxis der Datenschutzaufsicht und der nationalen und europäischen Privacy-Forschung mit. Gerade angesichts der europäischen Datenschutzreform (Tz. 2.2) will sich das ULD gestaltend einbringen, um die Konzepte wie „Privacy by Design“, „Privacy by Default“ und Datenschutzfolgenabschätzung zu konkretisieren. Damit sollen Entwickler, einsetzende Stellen, betriebliche Datenschutzbeauftragte, Standardisierungsgremien und Datenschutzbehörden in ihrem Bestreben nach einem guten Privacy-Niveau unterstützt werden.

https://www.forum-privatheit.de/

Was ist zu tun?

Der interdisziplinäre Diskurs zu Privacy-Themen muss lösungsorientiert geführt werden, um Wege für die Praxis zu finden.

8.2 eIDs, Identitätenmanagement und Datenschutz

Nutzergesteuertes Identitätenmanagement und vertrauenswürdige elektronische Ausweise (eIDs) sind von großer Bedeutung für die informationelle Selbstbestimmung in der digitalen Welt. Seit vielen Jahren engagiert sich das ULD für datenschutzfördernde Technik zum Identitätenmanagement, die mittlerweile Einsatzreife erlangt hat (Tz. 8.2.1). Trotz einer großen eID-Vielfalt in Europa gibt es leider wenig Datenschutz-Features. Vertrauenswürdige Identitätsvermittler zwischen verschiedenen technischen Systemen können bei geeigneter Gestaltung Nutzende in ihrem Datenschutz unterstützen (Tz. 8.2.2). Diese Forschungsarbeiten sind im größeren Kontext zu betrachten, da auf EU-Ebene im Sommer 2014 die Verordnung über elektronische Identifizierung und Vertrauensdienste für elektronische Transaktionen im Binnenmarkt in Kraft getreten ist (Tz. 11.6): Bei der Umsetzung dieser Verordnung sollten die in den Projekten entwickelten Datenschutzkonzepte berücksichtigt werden.

8.2.1 ABC4Trust – vertrauenswürdige digitale Authentisierung im Pilotversuch

Von November 2010 bis Februar 2015 hat das von der Europäischen Kommission geförderte Projekt „ABC4Trust – Attribute-based Credentials for Trust“ unter Beweis gestellt, dass datensparsame Berechtigungsnachweise praxistauglich sind. Die sogenannten Privacy-ABCs ermöglichen eine Authentisierung auch ohne Vorzeigen der Identitätsdaten.

Schon in den EU-Projekten „PRIME – Privacy and Identity Management for Europe“ (26. TB, Tz. 8.5) und PrimeLife (30. TB, Tz. 8.2) hat das ULD zum nutzergesteuerten Identitätenmanagement geforscht, wie sich mit datensparsamen Berechtigungsnachweisen in der digitalen Welt ein Mehr an Datenschutz erreichen lässt. Diese kryptografischen Techniken sind mittlerweile unter dem Begriff „Privacy-ABCs“ bekannt.

Um für diese Datenschutztechniken den Weg von der Forschung in die Praxis zu ebnen, beteiligte sich das ULD am EU-Projekt ABC4Trust (34. TB, Tz. 8.2), in dem die Erprobung dieser Privacy-ABCs in zwei Pilotversuchen im Mittelpunkt stand: in einem Kommunikationsnetzwerk an einer schwedischen Schule und in einem Kursevaluierungssystem an einer griechischen Universität.

Privacy-ABCs

Privacy-ABCs ist die Kurzform von „privacy-enhancing attribute-based credentials“, also ins Deutsche übersetzt: „datenschutzfördernde attributbasierte Berechtigungsnachweise“. Diese Privacy-ABCs vereinigen verschiedene kryptografische Mechanismen, denen gemeinsam ist, dass

1. die Nutzenden bestimmte Eigenschaften nachweisen können, ohne dass sie ihre Identität offenlegen müssen, und

2. diese digitalen Nachweise jedes Mal verschieden aussehen, sodass sie keine Verkettung erlauben und dadurch ein Nachverfolgen der Nutzenden nicht möglich ist.

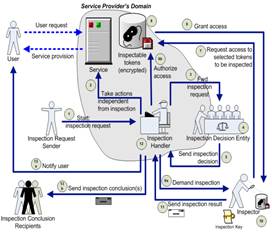

Man kann die Systeme so konfigurieren, dass ein Aufdecken hinterlegter verschlüsselter Daten für bestimmte vorab definierte (Missbrauchs-)Fälle unterstützt wird („Inspection“).

In den Pilotversuchen wurden die Nutzerinnen und Nutzer mit Chipkarten und Lesegeräten ausgestattet. So konnten sie ihre Privacy-ABCs, also ihre Berechtigungsnachweise, von einer Ausgabestelle herunterladen und lokal – auf der Chipkarte – speichern. Für eine Authentisierung zwischen Nutzer und einem Online-Service genügt ein direkter Datenaustausch ohne Einbindung einer weiteren Instanz; die Ausgabestelle ist an diesem Prozess unbeteiligt. Dies wirkt dem Erstellen von heimlichen Nutzungsprofilen entgegen. Je nach Realisierung verfügen die Privacy-ABCs über verschiedene Eigenschaften. Ähnlich dem elektronischen Personalausweis ermöglichen Privacy-ABCs den Nutzenden, nur solche Attribute auszuwählen und zu übertragen, deren Nachweis im Einzelfall erforderlich ist, um Zugang zu einem bestimmten Service zu erhalten. Die gesetzlichen Prinzipien der Datensparsamkeit und der Zweckbindung werden dadurch unterstützt.

An der griechischen Universität von Patras richtete das ABC4Trust-Projekt ein elektronisches Kursevaluierungssystem ein, das es den Studierenden ermöglichte, ihre Vorlesungen anonym zu bewerten. Das System stellte sicher, dass nur Studierende, die eine Mindestanzahl an Vorlesungen besucht hatten, an der Evaluierung teilnehmen konnten.

Mit dem zweiten Pilotversuch wurde erfolgreich ein Kommunikationsnetzwerk für die Schülerinnen und Schüler, Lehrkräfte und Eltern an der schwedischen Norrtullskolan in Söderhamn eingerichtet und betrieben. Die Nutzenden konnten pseudonym und zum Teil sogar anonym diskutieren, Kontakt zu Vertrauenslehrern aufnehmen und Dokumente austauschen.

Die Pseudonymität – statt vollständiger Anonymität – ergibt sich aus dem Umstand, dass in dieser Konfiguration der Privacy-ABCs die Identität der Nutzenden aufgedeckt werden kann, wenn die Inhalte ihrer Chats gegen im Vorfeld dargelegte Regeln verstoßen. Diese „Inspection“-Funktion lässt die Identifizierung der Nutzenden zu, wenn dies z. B. aufgrund gesetzlicher Bestimmungen möglich sein muss. Die Identität des Betroffenen bleibt – ganz im Sinne der Datensparsamkeit – geschützt, solange er sich regelkonform verhält. Weiterhin bietet dieses Vorgehen den Nutzenden Transparenz und Kontrolle über ihre Daten. Die rechtliche und technisch-organisatorische Ausgestaltung des „Inspection“-Prozesses mit definierten Verfahrensschritten (Überblick siehe Abbildung) gehörte neben der allgemeinen datenschutzrechtlichen Begleitung der Pilotentwicklung zu den Hauptaufgaben des ULD.

Quelle: ULD

http://www.abc4trust.eu/

Was ist zu tun?

Nachdem im Projekt ABC4Trust erfolgreich der Einsatz von Privacy-ABCs für zwei Szenarien getestet worden ist, müssen diese Erkenntnisse praktisch umgesetzt werden. Datenschutzfördernde Technik muss die Nutzenden erreichen. Es bedarf daher der gezielten Information von Politik und Wirtschaft über die Funktionsweise und Vorteile der Technologie sowie über geeignete Einsatzfelder. Insbesondere im Rahmen von Online-Abstimmungen, wie etwa Petitionen und Bürgerbegehren, können Privacy-ABCs ein adäquates Datenschutzniveau und die wünschenswerte Vertraulichkeit gewährleisten.

8.2.2 FutureID – vom Passwort zur anwendungsunabhängigen Chipkarte

Nach wie vor wirft die Verwendung sicherheitstechnisch unzureichender Authentisierungsverfahren, etwa mittels Benutzername und Passwort im Internet, große Probleme auf. Dabei sind sicherere Verfahren wie elektronische Ausweisdokumente bereits weitgehend verfügbar. Allerdings hapert es an der Unterstützung solcher elektronischen Identitätsnachweise, kurz eIDs.

Identity Brokerage (Identitätsvermittlung)Die Verwendung sogenannter Identitätsvermittler (Identity Broker) ermöglicht es Nutzenden, ihre vorhandenen eIDs auch für Dienste zu nutzen, die diese eIDs nicht selbst ausgestellt haben. So könnte mithilfe passender Identitätsvermittler beispielsweise ein elektronischer Personalausweis dazu dienen, einem Arzt in Italien direkten Zugriff auf eine in Frankreich vorgehaltene Patientenakte zu ermöglichen. Zudem ließen sich datenschutzfreundliche attributbasierte Nachweise, z. B. über das Alter einer Person, direkt aus einem geeigneten eID-Ausweis ableiten und über passende Identitätsvermittler auch dann einsetzen, wenn der Diensteanbieter die direkte Verwendung des eID-Ausweises nicht unterstützt. Die Hauptaufgabe der Identitätsvermittler ist dabei die technische Konvertierung der Identitäts- bzw. Attributsnachweise (siehe auch Privacy-ABCs, Tz. 8.2.1) zwischen zwei oder mehr Beteiligten. Dies muss selbstverständlich unter Einhaltung der rechtlichen Rahmenbedingungen erfolgen.

Das Einführen von eID-Systemen ist für Diensteanbieter ein Kostenfaktor, zumal im europäischen Kontext nicht nur ein Verfahren existiert, sondern sich eine heterogene Landschaft von untereinander nicht kompatiblen eID-Systemen entwickelt hat, die einzelne Anbieter kaum vollständig unterstützen könnten. Dies ist der Ausgangspunkt für das von der Europäischen Kommission geförderte Forschungsprojekt „FutureID – Shaping the Future of Electronic Identity“: Seit dem Projektstart im November 2012 forscht das ULD im Verbund mit 18 weiteren Partnern aus ganz Europa daran, geeignete Konzepte und Architekturen zu entwickeln, um die Konvertierung von Identitätsinformationen zwischen verschiedenen eID-Systemen datenschutzgerecht zu ermöglichen.

Die Kernaufgabe des ULD besteht in diesem Projektkontext darin, die datenschutzrechtlichen Anforderungen an ein solches Identitätsvermittlungssystem zu erarbeiten und ihre Einhaltung in den Projektergebnissen zu überprüfen. Im letzten Projektjahr wird das ULD auf Basis der erarbeiteten Anforderungen die FutureID-Pilotanwendungen und die konzipierten Komponenten evaluieren. Die flexible Referenzarchitektur von FutureID ermöglicht eine datenschutzfreundliche Realisierung und kann auch Datenschutztechniken wie Privacy-ABCs (Tz. 8.2.1) unterstützen. Allerdings muss darauf geachtet werden, dass die Identitätsvermittler nicht selbst zu einem Datenschutzrisiko mutieren.

Was ist zu tun?

Datenschutzanforderungen müssen nicht nur national, sondern auch in der europäischen eID-Landschaft realisiert werden. Vertrauenswürdige Identitätsvermittler können hier eine wesentliche Rolle spielen, solange sich datenschutzfreundliche Standards, die ohne weitere Instanzen auskommen, nicht durchgesetzt haben.

8.3 Cloud Computing

Immer mehr Datenverarbeitung findet nicht mehr lokal auf Geräten der Nutzerinnen und Nutzer statt, sondern ausgelagert in der Cloud. Cloud Computing ermöglicht die bedarfsgerechte Verwendung von Ressourcen, die von Cloud-Anbietern zur Verfügung gestellt werden. Damit befinden sich Daten und Programme nicht mehr unmittelbar im Herrschaftsbereich derjenigen, die für die Verarbeitung verantwortlich sind. Das ULD beteiligt sich an mehreren Projekten für mehr Datenschutz in der Cloud, um einem Kontrollverlust über die personenbezogenen Daten entgegenzuwirken. Während im europäischen Kontext an Multi-Cloud-Lösungen geforscht wurde (Tz. 8.3.1), beteiligt sich das ULD national an einem Projekt, das die Einflussbereiche der verschiedenen Dienstleister auf das Minimum beschränken soll (Tz. 8.3.2). Zudem ist das ULD an einem Projekt zur Datenschutzzertifizierung des Cloud Computing beratend beteiligt (Tz. 9.1).

8.3.1 TClouds – Datenschutzfolgenanalyse und mehr Vertrauenswürdigkeit für Cloud-Umgebungen

Ende 2013 wurde das von der EU geförderte Projekt „TClouds – Trustworthy Clouds“ abgeschlossen, das sich mit sicherem und mit den europäischen Datenschutzanforderungen vereinbartem Cloud Computing beschäftigte. Das ULD arbeitet weiterhin daran mit, Cloud-Lösungen im Einklang mit den rechtlichen Vorgaben auf europäischer Ebene zu entwickeln.

Nachdem der Schwerpunkt in der Anfangsphase auf der Zusammenstellung der europäischen rechtlichen Vorgaben und der Entwicklung von Lösungen in Bezug auf Cloud Computing gelegen hatte (34. TB, Tz. 8.4), konzentrierte sich die Arbeit im dritten und letzten Projektjahr auf die Evaluation der entwickelten TClouds-Komponenten und Prototypen. Hierzu erstellte das ULD rechtliche Gutachten zum Einsatz vertrauenswürdiger Cloud-Umgebungen – sowohl in den beiden projektspezifischen Anwendungsgebieten (medizinische Daten und Energiedaten) als auch im Hinblick auf Fragen des internationalen Datenaustausches.

Zudem führte das ULD ein Data Protection Impact Assessment (kurz DPIA) für die Cloud-Lösungen, die im Projekt entstanden sind, durch. Dieses Verfahren ermöglicht es, eine methodisch fundierte Aussage über Auswirkungen der Nutzung von Cloud-Technologien auf den Datenschutz und die informationelle Selbstbestimmung zu treffen. Die Betrachtung umfasst aktuelle wie auch zu erwartende zukünftige Auswirkungen und bietet sich dafür an, die rechtliche Einordnung und Bewertung dieser neuartigen Technologien zu unterstützen.

Data Protection Impact Assessment(Datenschutzfolgenanalyse)

Das Verfahren eines Data Protection Impact Assessment (zu Deutsch etwa: Datenschutzfolgenanalyse) nutzt eine wissenschaftlich fundierte Methodik, um neuartige Technologien hinsichtlich ihrer Auswirkungen auf den Datenschutz und die informationelle Selbstbestimmung einzuordnen. Ausgehend vom zu betrachtenden Anwendungsszenario wird dabei überprüft, welche Konsequenzen sich aus dem Einsatz der jeweils analysierten neuen Technologie ergeben und wie diese zu bewerten sind.

Da die Methodik für ein DPIA nicht genormt ist, entwickelte das ULD nach Auswertung bisheriger Vorschläge ein Verfahren auf Basis der Schutzziele des Datenschutzes (Nichtverkettbarkeit, Transparenz, Intervenierbarkeit) und der IT-Sicherheit (Vertraulichkeit, Integrität, Verfügbarkeit). Diese Methodik ermöglicht es, Anforderungen je nach Anwendungskontext verschieden stark zu gewichten. Der Ansatz hat sich bereits in vielen Projekten bewährt, z. B. in einer Studie zu altersgerechten Assistenzsystemen (33. TB, Tz. 6.3). Ziel ist sowohl die Nachvollziehbarkeit des Vorgehens als auch eine Vergleichbarkeit zwischen DPIAs mit ähnlichem Evaluierungsgegenstand, z. B. über ein IT-System, das sich über die Zeit weiterentwickelt.

Im Projekt TClouds wurde der koordinierte, gleichzeitige Einsatz mehrerer Clouds (Multi-Cloud, Cloud of Clouds) beleuchtet, woraus Vorteile für IT-Sicherheit und Datenschutz resultieren können. Dieser Forschungsansatz sollte weiterverfolgt werden.

http://www.tclouds-project.eu/

Was ist zu tun?

Bei der Konzeption neuer IT-Systeme sollten Datenschutzfolgenanalysen standardmäßig durchgeführt werden. Dabei sind insbesondere die Anforderungen der Nichtverkettbarkeit, der Transparenz und der Intervenierbarkeit zu berücksichtigen.

8.3.2 SPLITCloud – teile und herrsche

„Teile und herrsche“ – dieses bereits in der Antike bekannte Prinzip fördert die Beherrschbarkeit großer IT-Systeme und spielt in hochkomplexen Technologiefeldern wie dem Cloud Computing eine große Rolle. Denn hier greifen viele verschiedene Akteure mit jeweils ganz eigenen Interessen auf dasselbe Cloud-System zu.

Trusted ComputingDer Begriff „Trusted Computing“ umfasst eine Reihe technischer Maßnahmen, die dazu dienen, die Ausführung von Software auf Computern derart abzusichern, dass nur spezifisch zur Verwendung vorgesehene Programme überhaupt zur Ausführung gebracht werden können. Dies wird über die Verwendung diverser kryptografischer Verfahren erreicht, die zumeist in einem Hardware-Baustein direkt in den betroffenen Computern installiert sind.

Im Kontext des Cloud Computing kann die Verwendung solcher Trusted-Computing-Bausteine gewährleisten, das Basissystem der Cloud-Server derart zu starten und zu betreiben, dass ein administrativer Zugriff auf die Cloud-Server ausschließlich über explizit vorgegebene, wohldefinierte Schnittstellen möglich ist. Im Rahmen des SPLITCloud-Projekts soll diese Technologie weiterentwickelt werden, um eine logische Trennung zwischen den verschiedenen Domänen der Administratoren zu erreichen.

Der Cloud-Anbieter betreibt etwa die Server-Hardware, die er seinen Kunden, den Cloud-Nutzern, bereitstellt, die wiederum selbst Diensteanbieter sind. Diese implementieren ihre anwendungsspezifischen Dienste auf diesen Rechnern und bedienen damit Anfragen ihrer Dienstnutzer. In diesem Spannungsfeld kommt es häufig zu unklaren Situationen hinsichtlich des Verschuldens und der Verantwortung. Die technische Administration eines solchen Cloud-Systems ist komplex. Sowohl der Cloud-Anbieter als auch der Diensteanbieter haben Interesse daran, administrative Tätigkeiten wie die Installation aktueller Sicherheitsupdates in ihren Systemen durchzuführen. Folglich bedarf es administrativer Zugriffsrechte für beide Parteien. Dies wiederum wirft viele rechtliche Fragestellungen auf, besonders bei Konstellationen mit Partnern aus verschiedenen Ländern und legislativen Domänen.

Im Rahmen des vom Bundesministerium für Bildung und Forschung geförderten Projekts „SPLITCloud“ untersucht das ULD zusammen mit vier weiteren nationalen Partnern, wie sich dieses fundamentale Dilemma des sicheren und rechtskonformen Einsatzes von Cloud-Computing-Technologien lösen lässt. Im Fokus der Betrachtung steht dabei eine innovative Lösung zur Absicherung von Cloud-Systemen, die vertrauenswürdiges Rechnen (Trusted Computing) auf der Basis kryptografischer Protokolle realisiert.

Bei korrektem Einsatz kann diese Technologie es ermöglichen, die administrativen Domänen von Cloud-Anbieter und Cloud-Nutzer bzw. Diensteanbieter derart zu trennen, dass eine rechtskonforme Unterscheidbarkeit erreicht wird. Ziel des Projekts ist es, diese Fragestellungen zu bearbeiten und ein Konzept zu entwickeln, nach dem die Daten der Nutzer künftig besser gegen Einsichtnahme durch Administratoren geschützt sind.

http://www.vdivde-it.de/KIS/sichere-ikt/sicheres-cloud-computing/splitcloud

Was ist zu tun?

Sofern Unternehmen und Privatpersonen sich entscheiden, ihre Daten in einem Cloud-System zu speichern, müssen sie prüfen, welche Akteure Zugriff darauf haben können. Dabei sollten sie entsprechende Garantien verlangen, die durch technische Maßnahmen abgesichert sind.

8.4 Cybersicherheit und Datenschutz

In der digitalen Welt spielt sich mittlerweile ein Großteil des Lebens ab: Die Nutzerinnen und Nutzer kaufen online ein, buchen Reisen, erledigen Bankgeschäfte, versteigern Waren, kommunizieren mit Freunden und Verwandten, spielen und lernen im Cyberspace, lesen E-Books, reichen die Steuererklärung online ein und nutzen Dienstleistungen des E-Government. Ebenso verlassen sich Firmen und Verwaltungen auf das korrekte Funktionieren der Netze. Cybersicherheit ist aber keinesfalls garantiert; die heutigen Systeme sind verwundbar, und ständig müssen Angriffe abgewehrt werden. Das Ende 2014 von der Bundesregierung beschlossene IT-Sicherheitsgesetz sieht vor, Meldungen zu Sicherheitsvorfällen von Betreibern kritischer Infrastrukturen zusammenzuführen und auszuwerten (Tz. 2.3). Das ULD hat in den Jahren 2012 und 2013 für ähnliche Szenarien untersucht, inwieweit solche Meldungen personenbezogene Daten enthalten können und wie gewährleistet werden kann, dass der Datenschutz der Nutzerinnen und Nutzer nicht auf der Strecke bleibt (Tz. 8.4.1). Ein weiteres Cybersicherheitsprojekt startet Anfang 2015, das auf eine Erhöhung der Nutzersensibilität für Phishing-Angriffe zielt (Tz. 8.4.2).

8.4.1 MonIKA – Cybersicherheit und Anonymisierung

Bei der Bekämpfung von Botnetzen oder bei der Identifikation und Reduzierung von Spam-Mails spielen heutzutage kollaborative Systeme eine wichtige Rolle. Bei solchen Systemen versuchen mehrere Diensteanbieter, z. B. Internetprovider oder E-Mail-Anbieter, durch gezielten Austausch relevanter Informationen gemeinsam zu einer Erfassung der Lage im gesamten Verbund zu kommen.

Enterprise MonitoringDer Begriff des Enterprise Monitorings umfasst eine Reihe von Maßnahmen, die in Großkonzernen und in Verbünden kollaborierender Firmen eingesetzt werden, um sich ein Lagebild über den Zustand und die Bedrohungssituation der konzerninternen IT-Systeme zu verschaffen. Hierzu werden Daten über die Nutzung der internen Netze und Internetanbindungen erfasst, aufbereitet, untereinander ausgetauscht und ausgewertet, um ein möglichst umfassendes Gesamtbild der IT-Landschaft im Konzern bzw. im Verbund zu erstellen. Aus den derart gewonnenen Informationen lassen sich geeignete Maßnahmen zur Verbesserung der internen IT-Sicherheit und zur Abwehr laufender und künftiger Angriffe auf die IT-Systeme ableiten. Durch die Betrachtung der Verbundstruktur insgesamt ergeben sich dabei meist deutlich mehr und inhaltlich klarere Informationen über Schwachstellen und laufende Angriffe, als dies bei der Betrachtung einzelner lokaler Netze oder einzelner Firmennetze im Verbund möglich ist.

So können beispielsweise Muster aus bereits identifizierten Spam-Mail-Kampagnen zwischen den Verbundpartnern ausgetauscht werden, um zukünftige E-Mails derselben Spam-Kampagne effektiver auszufiltern. Ein Anwendungsgebiet kollaborativer Sicherheitssysteme liegt im Umfeld größerer Unternehmensverbünde (Enterprise Networks), bei denen verschiedene Unternehmen mit starken Abhängigkeiten untereinander, z. B. Zulieferer und Produzenten, zusammenarbeiten, um sich gemeinschaftlich gegen Angriffe auf ihre – oft intern vernetzte – IT-Struktur zu wehren. Auch hier werden Informationen zu digitalen Einbruchsversuchen und ungewöhnlichem Netzverhalten untereinander ausgetauscht, um groß angelegte Angriffsversuche frühzeitig zu erkennen und zu unterbinden.

Der hierbei erfolgende Datenaustausch zwischen verschiedenen Akteuren unterliegt jeweils besonderen datenschutzrechtlichen Vorgaben. Das Anfang 2014 erfolgreich abgeschlossene Projekt „MonIKA – Monitoring durch Informationsfusion und Klassifikation zur Anomalieerkennung“ (34. TB, Tz. 8.9) behandelte unter Mitwirkung des ULD diese Rechtsfragen.

In Zusammenarbeit mit der Rechtswissenschaftlichen Fakultät der Westfälischen Wilhelms-Universität Münster entstanden so zwei rechtliche Gutachten, die drei vorab definierte Szenarien hinsichtlich ihrer Rechtskonformität bewerten. Es zeigte sich, dass kollaborative Systeme zwar einen deutlichen und unverkennbaren Mehrwert gegenüber individuellen Maßnahmen erbringen können, dass sich aber nach aktuellem Stand ein rechtskonformer Betrieb in vielen Szenarien nicht oder nur sehr schwer realisieren lässt.

Für bestimmte Fragestellungen bieten clevere Anonymisierungsverfahren einen Lösungsansatz. Vielfach muss jedoch ein Personenbezug zumindest für einige der beteiligten Stellen bestehen bleiben, wobei mit geschickter Pseudonymisierung Datenschutzrisiken minimiert werden können. Hier besteht weiterer Forschungsbedarf.

Das MonIKA-Gutachten zur datenschutzrechtlichen Zulässigkeit sowie zum Einsatz und zur Gestaltung von Anomalie erkennenden Verfahren in Internetinfrastrukturen ist über die ULD-Webseite abrufbar.

https://www.datenschutzzentrum.de/projekte/monika

Was ist zu tun?

Beim Austausch und bei der Auswertung von Meldungen über Sicherheitsvorfälle müssen die Betreiber berücksichtigen, dass diese Daten häufig einen Personenbezug beinhalten. Für die Umsetzung des IT‑Sicherheitsgesetzes sind datensparsame Melde- und Analyseverfahren zu definieren.

8.4.2 Stärken des IT-Sicherheit sbewusstseins im Projekt ITS.APT

Um den Grad der IT-Sicherheit bei Betreibern kritischer Infrastrukturen zu prüfen, hat sich die Methode des Penetration Testing bewährt. Ein neues Projekt erweitert die Methode um eine – datenschutzfreundliche – Evaluation des Sicherheitsbewusstseins der Beschäftigten.

Penetration TestingIm Auftrag des Betreibers führen spezielle Dienstleister gezielte Angriffe auf ein laufendes IT-System durch. Dabei werden bekannte Schwachstellen der technischen Realisierung durchprobiert. Diese kontrollierten Angriffe dienen der Bewertung des Grads der IT-Sicherheit; erkannte Mängel können behoben werden. Das Sicherheitsbewusstsein der Beschäftigten beim Betreiber wird zumeist beim Penetration Testing nicht betrachtet, ist aber häufig für erfolgreiche Angriffe von großer Bedeutung.

Der Faktor Mensch ist nicht nur für Datenschützer ganz wichtig, sondern spielt auch eine wesentliche Rolle, wenn Angreifer versuchen, in ein IT-System einzudringen. Angreifer können z. B. an Passwörter von Beschäftigten gelangen, indem sie sie auf gefälschte Websites locken und dazu bringen, ihre Daten einzugeben. Beschäftigte mit höherem Sicherheitsbewusstsein fallen seltener auf solche Phishing-Angriffe herein.

Das vom Bundesforschungsministerium geförderte Projekt „ITS.APT – IT-Security Awareness Penetration Testing” wird Penetration Testing und die Prüfung des IT-Sicherheitsbewusstseins der Beschäftigten kombinieren und geeignete Schulungsmethoden entwickeln. Natürlich darf dies nicht zulasten des Beschäftigtendatenschutzes gehen. Im Projekt kommen Fachkräfte aus den Disziplinen Informatik, Jura und Psychologie zusammen, um mit Vertretern der Praxis aus dem Anwendungskontext Krankenhaus tragfähige Lösungen zu konzipieren.

Dem ULD kommt die Aufgabe zu, die datenschutzrechtlichen Anforderungen zu erarbeiten und deren Umsetzung auszuwerten.

https://www.datenschutzzentrum.de/projekte/its-apt/

Was ist zu tun?

Mitarbeiterinnen und Mitarbeiter müssen für Angriffe auf IT-Systeme sensibilisiert werden. Bei Verfahren zum Penetration Testing und zum Messen der Sicherheitsrisiken durch den Faktor Mensch müssen die Anforderungen des Beschäftigtendatenschutzes beachtet werden.

8.5 Big Data , soziale Netzwerke und Datenschutz

„Big Data“ war bis vor Kurzem noch ein wenig konturierter modischer Begriff, den die IT-Wirtschaft zur Werbung für technologisch etwas komplexere Innovationen benutzte. Das Bild hat sich in weniger als einem Jahr grundlegend geändert. Edward Snowden enthüllte, wie Big Data bei den Nachrichtendiensten von den USA und Großbritannien, der NSA und dem GCHQ, für die globale Netzüberwachung genutzt wird (Tz. 2.1). Der Einsatz für Sicherheitsbehörden in Europa erfolgt schon oder steht bevor (Tz. 8.5.3). Kommerziell wird Big Data – nicht nur von Facebook, Google oder Amazon, sondern auch von deutschen Kundenunternehmen – immer mehr eingesetzt (Tz. 8.5.2). Selbst in sensiblen Bereichen wie etwa im Gesundheitswesen wird diese Technik genutzt – nicht nur in den USA. Es gibt also genug Gründe, diese mit Heilsversprechen und Horrorszenarien verknüpfte Technik aus Datenschutzsicht zu entmystifizieren und zu gestalten.

Big Data ist begrifflich nicht klar umrissen. Es ist eine Sammelbezeichnung für umfangreiche, oft unstrukturierte Datenbestände, die zumeist im Rahmen einer Zweitverwertung zusammengeführt, verfügbar gemacht und – auch in Echtzeit – ausgewertet werden. Der Begriff steht für die auf der Grundlage gewaltiger Speicher- und Auswertungskapazitäten mögliche Datenanalyse zur Gewinnung neuer Erkenntnisse, mit denen gesellschaftliche, ökonomische oder politische Ziele realisiert werden können: sparsameres Produzieren und Wirtschaften, bessere Planungen und bessere Abläufe in Organisationen, sinnvolleren Ressourceneinsatz und höhere Transparenz.

Mithilfe der Analysewerkzeuge können oft personenbezogene, kontextübergreifende zeitliche Abläufe und digital erfasste Profile über Aufenthaltsorte, Sozialkontakte, Konsum, Verhalten, Interessen, Gesundheit etc. erstellt werden. Neudeutsche Stichworte sind hierfür Scoring, Tracking, Profiling, Personalizing. Verhaltensweisen können prognostiziert und bei Bedarf manipuliert werden. Möglich sind Diskriminierungsaktionen, indem ganz bestimmten Merkmalsträgern der Zugang zu, der Vertragsabschluss in Bezug auf oder die Nutzung von bestimmten Diensten verwehrt wird. Big Data – im politischen Bereich eingesetzt – wäre ein zentrales Instrument zur Verwirklichung einer digitalen Diktatur.

Big Data hat das ULD nicht nur im Rahmen von Forschungsvorhaben beschäftigt. Es war Thema der Sommerakademie 2013 (Tz. 13) sowie extern angeforderter Vorträge. Big Data muss Anlass zum gesetzgeberischen Tätigwerden sein, sowohl auf europäischer Ebene (Tz. 2.2) als auch in Spezialbereichen wie im Gesundheitswesen (Tz. 4.6.1) oder in Bezug auf Sicherheitsbehörden (Tz. 4.2).

https://www.datenschutzzentrum.de/artikel/212-.html

8.5.1 iGreen

Im Projekt „iGreen“ wurden Problembereiche des Datenschutzes in der Landwirtschaft in Form von Beratungsleistungen bearbeitet. In der Landwirtschaft findet inzwischen umfangreiche Datenverarbeitung statt. Landwirtschaftliche Maschinen sind mit GPS und Datenfunk ausgestattet, womit z. B. aktuelle Analysen der Bodenbearbeitung durchgeführt oder Zeit, Ort und Zustand von Gerätschaften überwacht werden. Rückschlüsse lassen sich nicht nur auf den Zustand etwa eines Feldes ziehen, sondern auch auf Arbeitsleistungen und finanzielle Verhältnisse des Agrarunternehmens. Die Hersteller und die ein Verfahren nutzenden Stellen sind dabei gehalten, den Datenschutz zu beachten.

Was ist zu tun?

Der Landwirt muss die Möglichkeit haben, selbst zu entscheiden, welche Daten an wen übermittelt werden. Dies muss für ihn ausreichend transparent und nachvollziehbar sein.

8.5.2 SPHERE – Kundenbeziehungsmanagement in sozialen Medien

Soziale Medien wie Facebook und Twitter, Bewertungsportale und Foren und die dabei anfallenden persönlichen Daten wecken Begehrlichkeiten bei Unternehmen. Sie möchten wissen, wie online über sie gesprochen wird, um ihr Vorgehen danach auszurichten. Vielleicht sind dort potenziell Kunden unterwegs. Gewaltige, scheinbar frei verfügbare Datenmengen aus den Profilen von Nutzern sozialer Netzwerke werden erhoben und ausgewertet. Die Ergebnisse können zu detaillierten Persönlichkeitsprofilen zusammengeführt werden. Diese werden genutzt für die Zusendung von individualisierter Werbung, die Gestaltung des Serviceangebots oder eine persönliche Ansprache auf dem Medium Internet. Meistens geschieht dies ohne Kenntnis der Betroffenen, die in der Regel wegen dieser Unkenntnis an der Ausübung ihrer Rechte gehindert sind. Eine Folge können gewichtige wirtschaftliche Nachteile sein.

Das ULD untersuchte in den vergangenen zwei Jahren im Rahmen des vom Bundesministerium für Bildung und Forschung geförderten Projekts „SPHERE – Shielding Privacy within CRM“ datenschutzrechtliche Fragestellungen zum Kundenbeziehungsmanagement in sozialen Medien. Am Projektkonsortium waren ein Hersteller von Kundenbeziehungsmanagement-Software, die bowi GmbH, sowie das Institut für Wirtschaftsinformatik der Universität Leipzig beteiligt.

Kundenbeziehungsmanagement (Customer Relationship Management – CRM) zielt auf die Gewinnung, Beibehaltung und Rückgewinnung von Kunden ab. Wichtige Anwendungsfelder sind das Marketing und der Service. Bei „Social CRM“ geht es um die Erhebung von Daten aus sozialen Netzwerken über ihre Speicherung und Zusammenführung in Profilen, ihre Veränderung zu Zahlenwerten, ihre Pseudonymisierung und Anonymisierung bis hin zur Nutzung zu werblichen und nicht werblichen Zwecken.

Ziel des Projekts war die Erstellung einer Software, welche als Komponente in ein CRM-System eingebunden werden kann. Sie soll auf der Grundlage von Parametern einer geplanten CRM-Maßnahme die Betroffenen warnen, falls diese datenschutzrechtlich problematisch ist. Hierfür wurden Fragebögen zu typischen Maßnahmen im CRM erstellt, deren Beantwortung eine allgemeine Risikoanalyse erlaubt. Die Hauptaufgabe des ULD bestand darin, anhand von Anwendungsszenarien die rechtlichen Rahmenbedingungen für einen datenschutzgerechten Betrieb von CRM-Systemen herauszuarbeiten. Im Folgenden werden einige wichtige wiederkehrende Leitlinien der Prüfung dargestellt:

- Daten in sozialen Medien sind oft allgemein zugänglich, allerdings aus Datenschutzgründen nicht frei erhebbar. Mit der Erhebung muss ein legitimer Zweck verfolgt werden. Zweckfreie Datensammlungen sind unzulässig. Ebenfalls verboten ist die Erhebung personenbezogener Daten zu Werbezwecken ohne Einwilligung. Der offenkundig entgegenstehende Wille des Betroffenen, der sich z. B. an herausgehobener Stelle aus dem Nutzerprofil erkennen lässt, ist eine weitere rechtliche Grenze.

- Daten, die ursprünglich allgemein zugänglich waren, können durch Zuspeicherung im CRM-System über die Verkettung zu sensiblen Daten werden, deren Nutzung für die verarbeitende Stelle rechtlich nicht mehr erlaubt ist.

- Daten sollen richtig und überprüfbar sein. Zwar gibt es bei der Erhebung von allgemein zugänglichen Daten keine grundsätzliche Prüfpflicht auf die Richtigkeit im Einzelfall. Eine Nutzung, die in Rechte von Betroffenen eingreift, darf jedoch nur aufgrund von zutreffenden Daten erfolgen. Dies schließt viele nicht einwilligungsbasierte Bewertungsverfahren auf der Basis von Social-Media-Daten aus.

- Die verantwortliche Stelle ist grundsätzlich nicht befugt, öffentlich Auskünfte über personenbezogene Daten mittels sozialer Medien zu erteilen. Eine Übermittlung an eine unbestimmte Anzahl Dritte verstößt oft gegen den Grundsatz der Erforderlichkeit. In der Regel ist nicht einmal sicher, ob eine Person die ist, für die sie sich ausgibt. Eine rechtliche Vermutung, dass es sich bei dem Fragenden um den Kunden handelt, besteht nicht. Selbst wenn das Vorliegen bestimmter personenbezogener Daten im CRM nur bestätigt und der Datenumfang scheinbar nicht erhöht wird, besteht die Gefahr eines Identitätsdiebstahls.

Was ist zu tun?

Hinsichtlich der Nutzung von Internetdaten für CRM muss bei den Verantwortlichen ein Bewusstsein für die Grenzen ihrer Verfügungsbefugnis über die fremden Daten hergestellt werden. CRM-Konzepte, die auf Anonymisierung und, wo dies nicht möglich ist, auf Transparenz gegenüber dem Betroffenen setzen, sind zu entwickeln und zu fördern.

8.5.3 VALCRI – Big Data für die Polizei

Im von der Europäischen Kommission geförderten Projekt VALCRI steht die datenschutzgerechte und ethisch vertretbare Realisierung eines Systems zur visuellen Datenanalyse für kriminalpolizeiliche Erkenntnisgewinnung im Vordergrund.

In dem im Mai 2014 gestarteten Projekt „VALCRI – Visual Analytics for Sense-Making in Criminal Intelligence Analysis“ wirken neben Universitäten und Wirtschaftsunternehmen zwei potenzielle Anwender mit: Polizei aus England und Belgien. Die Arbeit von Kriminalanalysten – nicht nur in diesen beiden Ländern – ist heute davon geprägt, dass sie mithilfe einer rudimentären technischen Ausstattung eine Vielzahl von Verbrechensberichten auswerten müssen, um Ähnlichkeiten im Modus Operandi oder andere Gemeinsamkeiten zu finden. Vor allem im Bereich der organisierten Kriminalität geht es um das Aufdecken und Verstehen komplexer Verbrechensnetzwerke. Das VALCRI-Projekt zielt darauf ab, verschiedene Technologien und Programme zur Datenvisualisierung und -analyse zu entwickeln und zu testen, um Daten effizienter zu verarbeiten und die Analysten technisch zu unterstützen. Komponenten zur Anonymisierung und zur elektronischen Zugangs- und Zugriffskontrolle sollen datenschutzrechtliche Anforderungen umsetzen.

Der Projektbeitrag des ULD befasst sich mit den grundlegenden Fragen der Datenverarbeitung durch Polizeibehörden: Neue Datenverarbeitungssysteme und die damit verbundenen technischen Möglichkeiten einer schnelleren und einfacheren Verarbeitung einer größeren Anzahl von Daten erfordern eine stetige Neubewertung bestehender Gesetze und ihrer Auslegung. Basierend auf dem Konzept der Schutzziele und dem „Privacy by Design“-Ansatz sollen Datenschutzanforderungen von Anfang an in die Technik integriert werden. Zusätzlich zu technischen Vorkehrungen umfasst das Projekt das Training von Kriminalanalysten an dem neuen System. Das ULD wird sich hier einbringen, um zu gewährleisten, dass technische Datenschutzmaßnahmen durch organisatorische Maßnahmen, wie z. B. Schulungen und interne Datenschutzbeauftragte, ergänzt werden. Ein enger Austausch besteht mit den Projektpartnern, die sich mit ethischen Fragen beschäftigen, sowie mit dem Ethik-Board des Projekts.

Die in dem Projekt gewonnenen Erkenntnisse werden vor allem nach Umgestaltung des europäischen Datenschutzrechts bedeutsam sein, da das Konzept „Privacy by Design“ zunehmend eine Rolle spielen wird, beispielsweise im kommenden Datenschutzregelungsrahmen (Tz. 2.2). Der im Projekt zu entwickelnde Prototyp soll ein Beispiel dafür sein, wie sich Datenschutz und effektive Polizeiarbeit in Einklang bringen lassen. Die Arbeit in dem Projekt VALCRI ermöglicht dem ULD, die anstehenden Veränderungen des europäischen Datenschutzrechts im Polizei- und Justizsektor zu begleiten, die sich in Deutschland auswirken werden.

Was ist zu tun?

In sensiblen Bereichen wie der Datenverarbeitung durch die Polizei ist es besonders wichtig, dass bei der Auswertung großer Datenmengen Datenschutzanforderungen von Anfang an berücksichtigt werden.

8.5.4 iTESA – Reisewarnungen unterwegs

Analyse von Big Data zum Zwecke der zielgruppengenauen Reisewarnung – unter welchen Bedingungen ist dies erlaubt? Damit beschäftigt sich das ULD im Anfang 2015 gestarteten Projekt „iTESA – intelligent Traveller Early Situation Awareness“.

Ziel von iTESA ist es, ein automatisches Frühwarnsystem für Reisende zu entwickeln. In Echtzeit können diese noch vor Reiseantritt vor möglichen Risiken, wie z. B. Epidemien und Naturkatastrophen, entlang der Reiseroute oder am Zielort gewarnt werden. Auf diesem Wege soll es ermöglicht werden, bereits bei der Reiseplanung, vor Reiseantritt, während der Reise und auch in Krisensituationen erforderliche Umbuchungen oder Umdispositionen vorzunehmen. Die Echtzeitwarnung, die den Reisenden beispielsweise auf ihre mobilen Endgeräte gesandt werden kann, soll das Ergebnis einer semantischen Auswertung von Daten aus öffentlichen Quellen sein. Das ULD kümmert sich in dem Projekt um die datenschutzrechtlichen, ethischen und gesellschaftspolitischen Fragen. Zunächst wird iTESA im Bereich des Reisemanagements erprobend eingesetzt; eine spätere Übertragung der im Projekt gewonnenen Erkenntnisse auf andere Gewerbezweige ist möglich.

Was ist zu tun?

Big-Data-Projekte sollten stets nach dem Prinzip „Privacy by Design“ entwickelt werden.

8.6 Sicherheit und Datenschutz

8.6.1 GES-3D – dreidimensionale Gesichtserkennung

Das im Jahr 2012 gestartete Projekt „GES-3D – Multi-Biometrische Gesichtserkennung“ sollte ein Verfahren entwickeln, das die polizeiliche Identifizierung von Straftätern aus tatrelevanten Foto-/Videodaten mittels Abgleich mit 3D-Gesichtsbilddaten ermöglicht (34. TB, Tz. 8.8). Das ULD sollte im Rahmen einer rechtlichen Analyse u. a. die rechtliche Zulässigkeit des Einsatzes als auch die datenschutzrechtlichen Anforderungen an die technische Ausgestaltung eines derartigen Systems untersuchen.

Der Einsatz eines 3D-Gesichtserkennungssystems bringt nicht nur Vorteile, sondern verursacht auch beträchtliche Kontroll- und Überwachungsrisiken für die Bürgerinnen und Bürger. Diesbezüglich wurden auch die im Jahr 2013 bekannt gewordenen Überwachungspraktiken der amerikanischen und britischen Geheimdienste in die Beurteilung einbezogen. Die Analyse der datenschutzrechtlichen Zulässigkeit erfolgte exemplarisch für einige reale Einsatzmöglichkeiten sowohl aus dem öffentlichen als auch aus dem nicht öffentlichen Bereich. Relevant sind für die Zulässigkeit der konkrete Einsatzzweck sowie die technische Ausgestaltung des Systems. Ein Bewertungskriterium für die Zulässigkeit ist bei einem hoheitlich veranlassten Einsatz beispielsweise, ob eine große Menge von unbeteiligten und damit unbescholtenen Bürgern betroffen ist.

Für den Einsatz im nicht öffentlichen Bereich besteht ein breites Spektrum an Einsatzmöglichkeiten. Neben der technischen Ausgestaltung kommt es bei der Antwort auf die Frage nach der Zulässigkeit hier auf die Abwägung der widerstreitenden Interessen der Daten verarbeitenden Stelle und des Betroffenen an. Untersucht wurde diesbezüglich auch, ob wirksam in die mit dem Einsatz des Gesichtserkennungssystems einhergehende Datenverarbeitung eingewilligt werden kann.

Aus den Untersuchungsergebnissen der Analyse ergeben sich Anforderungen sowohl an den Gesetzgeber als auch an die Hersteller und Anwender:

- Aufgabe des Gesetzgebers ist es, der Konzeption neuer Technologien und der daraus entstehenden Einsatzbegehrlichkeiten durch die Entscheidung Rechnung zu tragen, ob und in welchen Grenzen innovative Technologien eingesetzt werden dürfen. Dabei ist zu beachten, dass die verfassungsrechtlichen Grenzen einer uneingeschränkten Nutzung entgegenstehen.

- Die Hersteller müssen datenschutzrechtliche Gestaltungsanforderungen an ihr System einhalten und bereits bei der Grundkonzeption des Systems den Ansatz „Privacy by Design“ (PbD) berücksichtigen. Die Hersteller sind gehalten, die Technologie weder Unrechtsstaaten noch Staaten, die sich durch ein geringes bzw. fehlendes Datenschutzniveau auszeichnen, zur Verfügung zu stellen und dafür Sorge zu tragen, dass sich die mit dieser innovativen Technologie einhergehenden Risiken, die insbesondere in Unrechtsstaaten zu einer Gefahr für Leib und Leben erwachsen können, nicht realisieren.

- Die Anwender sind gehalten, die Technologie nur im Rahmen des datenschutzrechtlich Zulässigen anzuwenden. Sie haben dafür Sorge zu tragen, dass die zulässig verwendeten personenbezogenen Daten gegen unberechtigte Zugriffe gesichert sind. Dies gilt für öffentliche und nicht öffentliche Stellen – Unternehmen oder Privatleute – gleichermaßen.

Angesichts stetig zunehmender Begehrlichkeiten nach Überwachungsmedien seitens der Politik und Sicherheitsbehörden sowie eines gewissen gesellschaftlichen Desinteresses und eines sich schnell und stetig entwickelnden technischen Fortschrittes ist die Entwicklung eines verstärkten gesellschaftlichen und politischen Bewusstseins für das Recht auf informationelle Selbstbestimmung unerlässlich. Dieses Bewusstsein muss dazu führen, dass Gesichtserkennung – wie bei anderen Systemen auch – mit der nötigen Sensibilität angewandt und nicht der Rahmen des technisch Möglichen, sondern allenfalls der Rahmen des rechtlich Zulässigen ausgeschöpft wird.

Was ist zu tun?

Dreidimensionale Gesichtserkennung stellt dem Gesetzgeber, den Herstellern und den Anwendern hohe Anforderungen für eine datenschutzgerechte Konzeption und einen entsprechenden Einsatz.

8.6.2 SurPRISE – Bürger äußern ihre Meinung zum Thema „Überwachung, Sicherheit und Privatsphäre“

SurPRISE ist ein von der EU gefördertes und im Februar 2012 begonnenes Projekt, das die Sichtweise europäischer Bürgerinnen und Bürger im Hinblick auf das Spannungsverhältnis zwischen Sicherheit und Privatsphäre untersucht (34. TB, Tz. 8.7). Kern des Projekts ist die Beteiligung der Bürger zu der Frage des Verhältnisses von Überwachung, Privatsphäre und Sicherheit. Die Projektpartner führten hierzu in neun europäischen Ländern ganztägige Bürgerforen durch. Das ULD organisierte im Frühjahr 2014 in Kiel ein Bürgerforum, wo die 190 Teilnehmenden gemeinsam zum Thema „Staatliche Überwachung und Privatsphäre“ diskutierten und Handlungsempfehlungen für die Politik erarbeiteten.

Das Bürgerforum hatte zwei Schwerpunkte: Zunächst wurden zwei beispielhafte überwachungsbasierte Sicherheitstechnologien, die sogenannte intelligente Videoüberwachung und die Ortung bzw. Verfolgung von Mobilgeräten durch Sicherheitsbehörden, thematisch behandelt. Dann erhielten die Teilnehmenden die Möglichkeit, sich allgemein zu dem Themenkomplex Überwachung, Sicherheit und Privatsphäre zu äußern und ihre Meinung darüber unabhängig von einer spezifischen Technologie kundzutun, auch in Form konkreter Empfehlungen an die Politik – primär auf europäischer, aber auch auf nationaler Ebene.

Bei dem vom ULD organisierten deutschen Bürgerforum wurde deutlich, dass sich die Menschen ein Bewusstsein für die Notwendigkeit des

Einsatzes überwachungsbasierter Technologien zum Schutz der öffentlichen Sicherheit haben. Auch kristallisierte sich heraus, dass die Bürgerinnen und Bürger die damit einhergehenden Eingriffe in die Privatsphäre nicht ohne Weiteres akzeptieren. Die Veranstaltung offenbarte ein Meinungsbild von Sorgen über das teilweise erhebliche Missbrauchspotenzial solcher Technologien und der damit erhobenen Daten. Die oftmals nicht nachgewiesene Effektivität jener Technologien für die Erhöhung öffentlicher Sicherheit wurde bemängelt. Die Teilnehmenden zeigten ein vielschichtiges Bild von den angesprochenen Themen und bezogen dabei auch die langfristigen und gesellschaftlichen Auswirkungen staatlicher Überwachung mit ein. Das Bürgerforum legte offen, dass die gegenwärtige Sicherheitspolitik in Deutschland und Europa von vielen als zu einseitig empfunden wird – zum Nachteil der Privatsphäre des Einzelnen wie der Gesellschaft als Ganzes. Es wurde deutlich, dass die Annahme einer automatischen Akzeptanz von überwachungsbasierten Sicherheitstechnologien angesichts erhöhter Sicherheitsrisiken falsch ist. Vielmehr legten die Teilnehmer des Bürgerforums Wert auf die Feststellung, dass sowohl Sicherheit als auch Privatsphäre gleichermaßen bedeutende Güter sind. Eine ernsthafte, objektive und kritische Reflexion hinsichtlich dieser Themen seitens der Politik und der Sicherheitsbehörden wurde vermisst. Die Teilnehmer forderten eine ausgewogenere Balance zwischen Sicherheit und Privatsphäre, was sich in den formulierten Empfehlungen widerspiegelt:

- weniger Überwachung insgesamt, um eine negative Auswirkung auf die Privatsphäre im Allgemeinen zu reduzieren,

- mehr Transparenz gegenüber den Bürgern,

- zwingende, objektive und gründliche Evaluation von überwachungsbasierten Sicherheitstechnologien, insbesondere in Bezug auf

- Geeignetheit,

- Erforderlichkeit,

- Effektivität

- und Verhältnismäßigkeit,

- das Vorantreiben eines harmonisierten EU-Datenschutzrechts, welches sich hinsichtlich des Schutzniveaus am deutschen Datenschutzrecht als Mindeststandard orientiert,

- effektive Möglichkeiten der Kontrolle und Durchsetzung von Datenschutz.

Diese Empfehlungen werden zusammen mit weiteren Forschungsergebnissen des SurPRISE-Projektes, etwa zu Möglichkeiten datenschutzgerechter Gestaltung von Sicherheitstechnologien, in einen Anforderungskatalog für die Akzeptanzfähigkeit des Einsatzes staatlicher Sicherheitstechnologien einfließen. Dieser Katalog wird als Hilfestellung für die Gestaltung von Sicherheitsstrategien und für entsprechende legislative Maßnahmen auf europäischer Ebene dienen. Die Übersetzung des Länderreports mit den Ergebnissen des deutschen Bürgerforums ist in Arbeit. Das englische Original ist auf der offiziellen Webseite abrufbar als PDF-Dokument D6.3 (Country Report Germany) unter:

http://surprise-project.eu/dissemination/research-results/

8.7 Betroffenenrechte

8.7.1 Datenschutz-Auskunftsportal – eigentlich eine gute Idee

Viele Menschen wissen nicht, dass sie ein Recht auf Auskunft über ihre personenbezogenen Daten haben – sowohl gegenüber Unternehmen als auch gegenüber der Verwaltung. Selbst wer den datenschutzrechtlichen Auskunftsanspruch kennt, hat es heute nicht leicht, davon effektiv Gebrauch zu machen. Abhilfe könnten Datenschutz-Auskunftsportale schaffen.

Das Forschungsprojekt „Datenschutz-Auskunftsportal“ wurde ab August 2011 für 15 Monate vom Bundesministerium für Ernährung, Landwirtschaft und Verbraucherschutz (BMELV) gefördert (34. TB, Tz. 8.5). Ziel des Projekts war es, den Aufwand für Verbraucherinnen und Verbraucher bei der Wahrnehmung ihres Auskunftsrechts deutlich zu verringern. Entstanden ist ein Konzept für ein Datenschutz-Auskunftsportal, d. h. eine Internetplattform, die Folgendes leistet:

- Unterstützung der Nutzenden bei der Formulierung ihrer individuellen Anfragen und die Adressierung direkt an die Unternehmen,

- Bereitstellung allgemeiner Informationen zum Auskunftsrecht sowie standardisierter Schreiben an die Unternehmen sowie

- Erleichterung für die Unternehmen durch Tools zur prozessgestützten Bearbeitung der Auskunftsersuchen.

Keinesfalls darf ein solches Datenschutz-Auskunftsportal selbst zu einer Sammelstelle personenbezogener Daten werden. Eine vertrauenswürdige und sichere Realisierung ist notwendige Bedingung für den Betrieb. Es wurde ein Labormuster einer Internetplattform erstellt, mit dem das Potenzial für die Betroffenen deutlich wird. Der Schritt zum regulären Betrieb bedürfte weiterer Fördermittel. Die Projektidee liegt also vorläufig auf Eis. Interessierte können aber von der Ausarbeitung des ULD zu den datenschutzrechtlichen Aspekten profitieren.

https://www.datenschutzzentrum.de/projekte/auskunftsportal/

Was ist zu tun?

Unternehmen sollten aktiv über ihre Datenverarbeitung informieren und die Hemmschwelle für das Wahrnehmen von Betroffenenrechten senken. Die Realisierung eines Auskunftsportals sollte weiterverfolgt werden.

8.7.2 Studie: Scoring nach der Datenschutznovelle 2009

Die Bewertung von Verbraucherinnen und Verbrauchern durch Wirtschaftsunternehmen mithilfe von sogenannten Scoringverfahren hat mit den stetig wachsenden Möglichkeiten der Auswertung von Daten in „Big Data“-Beständen erheblich zugenommen. Das ULD wurde zusammen mit der GP Forschungsgruppe vom Bundesministerium der Justiz und für Verbraucherschutz (BMJV) mit der Studie „Scoring nach der Datenschutznovelle 2009 und neue Entwicklungen“ beauftragt. Die Studie behandelt die Frage, ob die mit der Novelle des Datenschutzrechts eingeführten Neuerungen einen angemessenen Schutz der Verbraucherinnen und Verbraucher ermöglichen. Dazu wurden die rechtlichen Grundlagen des Scorings untersucht und Betroffene und Unternehmen zur Scoringpraxis befragt.

Der Einfluss von Scorewerten auf Geschäftsentscheidungen über Kredite, Vertrags- oder Versicherungskonditionen wird – sogar im Medizinbereich – immer größer; der Aussagegehalt ist in vielen Fällen für die Betroffenen beschränkt und nicht nachvollziehbar. Unbekannte Datenquellen und wenig transparente Berechnungsverfahren machen das Scoring undurchschaubar.

Die Studie stellt fest, dass die Datenschutznovelle für Banken und Auskunfteien Auswirkungen hinsichtlich ihres Auskunftsverhaltens hatte, Beeinträchtigungen der Verbraucherrechte aber weiter bestehen. Die kostenlose Selbstauskunft ist vielen Betroffenen weitgehend unbekannt. Erteilte Auskünfte sind oft unverständlich und nicht plausibel. Scores sind prognostische Schätzungen, deren individueller Aussagegehalt oft fragwürdig ist. Es besteht Nachbesserungsbedarf bei der Bestimmung der zulässigen Datenarten und Quellen.

Die Kontrolle der Scoringverfahren erfolgt nur unzureichend, weil die Relevanz der verarbeiteten Daten für die Prognosegüte und deren Gewichtung in mathematisch-statistischen Verfahren ohne Offenlegung der Modelle weder durch die Betroffenen noch durch die Aufsichtsbehörden wirksam überprüft werden können. Die Geheimhaltung der algorithmusbasierten Berechnungen ist zu hinterfragen. Angesichts dieser Situation sind die bestehenden Regelungen für neue Scoringformen mit aus dem Internet stammenden Daten zum Schutz des Grundrechts auf informationelle Selbstbestimmung nicht ausreichend.

Was ist zu tun?

Die Transparenz über Scoringergebnisse kann durch eine inhaltlich präzisierte Auskunftspflicht der Unternehmen verbessert werden. Scoringverfahren sollten einer Qualitätsprüfung im Rahmen einer Zulassung unterzogen werden. Die Regelungen sollten nicht nur für Vertragsverhältnisse, sondern auch für andere besonders eingriffsintensive Anwendungen gelten.

| Zurück zum vorherigen Kapitel | Zum Inhaltsverzeichnis | Zum nächsten Kapitel |